La inteligencia artificial (IA) se ha convertido en uno de los motores de transformación más potentes del siglo XXI, revolucionando industrias, modelos de negocio y la vida cotidiana de millones de personas. Sin embargo, su rápido desarrollo ha generado preocupaciones significativas e infinidad de interrogantes sobre la privacidad, la seguridad, y los derechos de los ciudadanos. A medida que las capacidades de la IA avanzan a un ritmo sin precedentes, los gobiernos y organismos internacionales se enfrentan al desafío urgente de establecer regulaciones que garanticen un uso seguro y equitativo de esta tecnología. Este artículo explora los esfuerzos globales para regular la IA, las tensiones entre innovación y control, y el impacto potencial de estas normativas en el futuro de las relaciones internacionales.

Tecnologías 2.0 y la competencia por el poder

La inteligencia artificial (IA) se ha posicionado como un tema crucial en la agenda de las relaciones internacionales, impulsando debates sobre su regulación y uso responsable. El reto de regular la IA va más allá de las fronteras nacionales, convirtiéndose en un campo de competencia y cooperación entre Estados que buscan liderar la transformación digital.

El teórico realista Hans Morgenthau, uno de los padres fundadores del realismo clásico, argumentó que "la política internacional, como toda política, es una lucha por el poder" y que los Estados actúan en función de sus intereses nacionales, definidos en términos de poder y seguridad.

Aplicando esta perspectiva al campo de la tecnología, la IA se ha convertido en un nuevo escenario de competencia por la dominación global, donde los Estados buscan asegurarse una ventaja estratégica. Esta competencia no solo se manifiesta en el desarrollo y la implementación de tecnologías avanzadas, sino también en la definición de los marcos normativos que regirán su uso.

El presente artículo selecciona a los miembros del G7 y a China para abordar la interacción entre la inteligencia artificial (IA) y las relaciones internacionales debido a su papel preeminente en la economía global, su liderazgo tecnológico y su influencia en la configuración de marcos regulatorios internacionales. Los países del G7 —Canadá, Francia, Alemania, Italia, Japón, Reino Unido y Estados Unidos— representan algunas de las economías más avanzadas y con mayores capacidades tecnológicas del mundo. Su enfoque hacia la IA no solo refleja sus propias prioridades nacionales, sino que también establece estándares globales que otros países tienden a seguir.

Por otro lado, China se presenta como un competidor clave en el ámbito de la IA, impulsando una estrategia que combina innovación con un fuerte control estatal. La inclusión de China en este análisis es fundamental, ya que representa una perspectiva distinta, orientada más hacia la vigilancia y el control que a la regulación basada en derechos, lo cual desafía los enfoques occidentales y crea una competencia tecnológica y normativa en la arena internacional.

Elegir a estos actores permite explorar un contraste significativo entre las democracias liberales del G7, que buscan equilibrar la innovación con la protección de derechos, y China, cuyo modelo autoritario aprovecha la IA para reforzar el control social y económico. Además, tanto los países del G7 como China desempeñan un papel crucial en las negociaciones multilaterales sobre la regulación de la IA, influyendo en organismos internacionales como la OCDE, la ONU y otras plataformas de cooperación global.

Regulación de la IA en el G7: estrategias y desafíos

Los países del G7 adoptaron enfoques diversos para regular la IA, adaptándolos a sus contextos nacionales y prioridades estratégicas. La Unión Europea (UE) ha sido pionera en este ámbito con su propuesta de la Ley de IA, que establece un marco regulatorio detallado clasificando los sistemas de IA según su nivel de riesgo, desde inaceptable hasta mínimo. Esta normativa pretende prohibir usos que vulneren derechos fundamentales, como la vigilancia masiva y la manipulación psicológica, mientras que impone requisitos estrictos para aplicaciones de alto riesgo, como el reconocimiento facial y la toma de decisiones judiciales.

La Ley de IA es el primer marco jurídico integral sobre IA en todo el mundo. El objetivo de las nuevas normas es fomentar una IA fiable en Europa y en otros lugares, garantizando que se respeten los derechos fundamentales, la seguridad y los principios éticos y abordando los riesgos que esta tecnología conlleva.

Puntualizando en el caso del Reino Unido, su interés por la IA se revitalizó tras el Brexit, buscando nuevas fuentes de crecimiento económico. En 2018, se impulsaron recomendaciones para incentivar la inversión y atraer talento al sector, y se acordó un financiamiento de 1.000 millones de libras para promover su adopción. En 2021, el Reino Unido presentó su estrategia para convertirse en una superpotencia de IA, y en 2023 confirmó un enfoque regulador ligero, buscando equilibrar innovación y gobernanza efectiva. En ese mismo año publicó un libro blanco que establece directrices para el desarrollo de tecnologías que respeten los derechos individuales, pero nada indica que existan planes a futuro para establecer una regulación central sobre inteligencia artificial.

Por otra parte, en Estados Unidos, la regulación de la IA aún no ha sido unificada a nivel nacional, pero el país ha adoptado normativas sectoriales y guías éticas que se centran en promover la innovación y la competitividad. En 2020, la Ley de Iniciativa Nacional de Inteligencia Artificial estableció una Iniciativa Estadounidense de IA y orientaciones sobre las actividades de investigación, desarrollo y evaluación de la IA en los organismos científicos federales.

La promulgación de esta ley constituyó un marco de regulación que subraya la necesidad de un enfoque flexible para evitar frenar el desarrollo tecnológico, al tiempo que garantiza la seguridad y la transparencia. Además, la Ley de Responsabilidad Algorítmica de 2022 se presentó en ambas cámaras del Congreso en febrero de 2022. Finalmente, en la sesión legislativa de 2024, al menos 40 estados presentaron proyectos de ley sobre inteligencia artificial, y seis estados adoptaron resoluciones o promulgaron leyes.

Japón, por su parte, ha integrado la IA en su visión de la Sociedad 5.0, un concepto que busca aplicar la tecnología de manera inclusiva en todos los aspectos de la vida social y económica. En 2019, el gobierno japonés publicó los Principios sociales de la IA centrada en el ser humano como principios para implementar la IA en la sociedad. Es importante señalar que el objetivo de los principios sociales no es restringir el uso de la IA para protegerlos, sino hacerlos realidad a través de la IA. Esto corresponde a la estructura de los “Principios de IA de la Organización para la Cooperación y el Desarrollo Económicos” (OCDE).

Por último, Canadá fue uno de los primeros países del mundo en proponer una ley para regular la IA. Se espera que Canadá regule la IA a nivel federal, a través de la Ley de Inteligencia Artificial y Datos (AIDA), que forma parte del Proyecto de Ley C-27. Sin embargo, no está claro cuándo entrará en vigor la AIDA; todavía no ha sido votada en el comité y hay algunas dudas sobre si se aprobará antes de octubre de 2025.

El gigante asiático y sus avances en materia de inteligencia artificial

Por último, y no por ello menos importante, China se destaca como un líder global en el desarrollo y uso de la IA, especialmente en campos como el reconocimiento facial, la vigilancia y el comercio electrónico.

Sin embargo, su enfoque regulatorio está profundamente influenciado por las prioridades del Estado en términos de control y seguridad nacional, más que en la protección de los derechos individuales. En 2021, China introdujo directrices éticas para la IA, que establecen principios de "IA confiable", buscando equilibrar la innovación con un fuerte control sobre los riesgos. A pesar de estos esfuerzos, China ha recibido críticas internacionales por su uso extensivo de la IA en la vigilancia ciudadana y la censura, lo cual ha planteado serias preocupaciones sobre los derechos humanos.

En la Asamblea Popular Nacional (APN) de marzo de 2024, el gobierno chino destacó sus principales prioridades, situando en primer lugar el desarrollo de "nuevas fuerzas productivas", un término reciente que refleja su enfoque en impulsar el sector de alta tecnología. Mientras China se aleja de un modelo de crecimiento centrado en la propiedad y la infraestructura, la promoción de la innovación y el avance tecnológico ha sido una constante en su discurso oficial.

A pesar de los desafíos planteados por las sanciones lideradas por Estados Unidos, China demostró resiliencia e innovación, lo que reforzó su papel como actor importante en el futuro de la IA.

El enfoque de China en las tecnologías 2.0 tiene un doble propósito: contrarrestar la política económica de Estados Unidos y abordar los desafíos económicos internos.

La demostración de sistemas avanzados, incluidos viajes gratuitos en vehículos sin conductor, tiene como objetivo promover la comercialización y generar confianza pública en las máquinas automatizadas. Shanghái, un centro líder para el desarrollo de la IA en China, conocido por su modelo de innovación en clústeres, ha ganado atención mundial a través de la Declaración de Shanghái, que podría atraer inversión extranjera.

Desafíos éticos y legales de la inteligencia artificial

En el Handbook of Machine Learning, por ejemplo, se describen en profundidad las complejidades de estas tecnologías. Como demuestra el libro, hay tres grandes tipos de IA: máquinas de predicción, máquinas de agrupamiento y máquinas generativas.

Las máquinas de predicción pronostican resultados futuros o hacen predicciones basadas en datos históricos. Las máquinas de agrupamiento agrupan puntos de datos similares en función de características específicas. Las máquinas generativas, como ChatGPT, crean contenido nuevo, como imágenes, texto o incluso música, que se asemeja al contenido creado por humanos basándose en algoritmos que aprenden patrones de los datos existentes.

Como consecuencia, la regulación de la IA enfrenta desafíos éticos complejos, como el sesgo algorítmico, que puede perpetuar la discriminación, y el uso de la IA en la vigilancia masiva. Ejemplos incluyen el reconocimiento facial utilizado por las fuerzas del orden en EE. UU., que ha generado preocupación por las violaciones de privacidad y el impacto desproporcionado sobre minorías.

Además, la IA se está utilizando en áreas sensibles como la justicia penal, la atención médica y el empleo, donde errores en los algoritmos pueden tener consecuencias graves. La falta de transparencia en el funcionamiento de algunos sistemas de IA (la llamada "caja negra") dificulta la rendición de cuentas y la corrección de errores.

Es por esto por lo que comprender cómo funciona esta tecnología es un paso esencial para afrontar este desafío. Los sistemas de IA transparentes son esenciales para generar confianza entre los usuarios y garantizar la rendición de cuentas.

El futuro de la regulación: ¿hacia una gobernanza global de la IA?

La creciente preocupación sobre los impactos de la IA ha impulsado a los organismos internacionales a proponer marcos globales de gobernanza. La OCDE y la Unesco han emitido principios sobre la IA ética, y las Naciones Unidas han iniciado debates sobre la regulación de tecnologías emergentes. Sin embargo, alcanzar un consenso global es complicado debido a las diferencias en los enfoques nacionales y los intereses geopolíticos.

Un ejemplo de cooperación internacional es el Global Partnership on AI (GPAI), una iniciativa liderada por países del G7 y otros, como India, que busca desarrollar y compartir mejores prácticas en la regulación y uso ético de la IA. Esta colaboración representa un paso hacia la gobernanza global, pero aún enfrenta desafíos en la implementación de normativas efectivas y acordadas por todos.

La regulación de la IA enfrenta desafíos éticos y legales complejos, como el sesgo algorítmico y la falta de transparencia en la toma de decisiones automatizadas. Estos problemas son evidentes en el uso de sistemas de reconocimiento facial por parte de las fuerzas del orden en países como Estados Unidos, donde han surgido preocupaciones sobre el impacto desproporcionado en minorías y la violación de la privacidad. Además, la opacidad de los algoritmos, a menudo referida como "caja negra", dificulta la rendición de cuentas y la corrección de errores, especialmente en áreas sensibles como la justicia penal, la atención médica y el empleo.

A nivel internacional, la gobernanza de la IA está siendo abordada por diversas instituciones. La Organización para la Cooperación y el Desarrollo Económicos (OCDE) y la Unesco han emitido directrices sobre la IA ética, mientras que las Naciones Unidas han abierto debates sobre la necesidad de establecer normativas globales para las tecnologías emergentes.

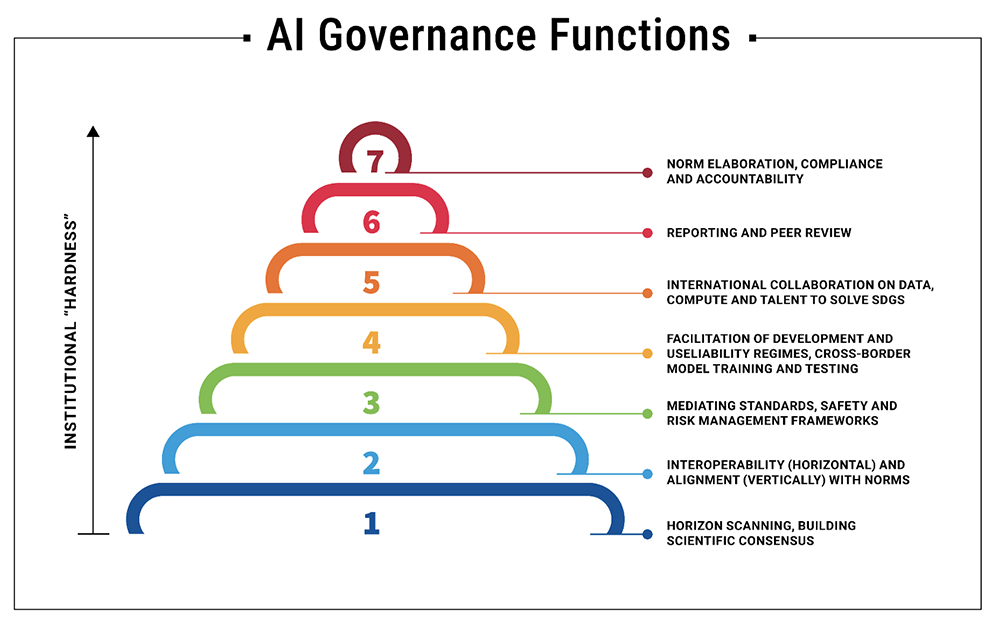

El Órgano Asesor sobre Inteligencia Artificial del Secretario General de las Naciones Unidas ha publicado su informe provisional. La parte central del documento propone siete funciones fundamentales para fortalecer la gobernanza global de la IA. Algunas de ellas son: la exploración del horizonte de los riesgos y el apoyo a la colaboración internacional en materia de datos, capacidad informática y talento para alcanzar los Objetivos de Desarrollo Sostenible (ODS).

En virtud de lo desarrollado hasta el momento se puede afirmar que el futuro de la regulación de la IA dependerá de la capacidad de los países y organismos internacionales para colaborar en la creación de estándares globales que no solo promuevan la innovación, sino que también protejan los derechos fundamentales y garanticen un uso seguro y equitativo de esta tecnología transformadora. La IA se ha convertido en un nuevo frente en la política internacional, donde los Estados no solo compiten por la supremacía tecnológica, sino también por definir los marcos éticos que guiarán el futuro de esta poderosa herramienta.